Come connettere ChatGPT con le tue macchine

Parla con le tue macchine: Come il Model Context Protocol sta rivoluzionando l'AI per macchine e dispositivi connessi

Sara Strizzolo

22 Luglio 2025

Gli strumenti LLM sono una delle interfacce più usate dalle aziende per connettere e semplificare l’interazione tra gli utenti e le proprie applicazioni. Ad oggi è possibile anche con macchine e dispositivi fisici. Ma come è possibile connettere gli LLM alle macchine? Attraverso il Model Context Protocol (MCP).

Cos’è il Model Context Protocol (MCP)?

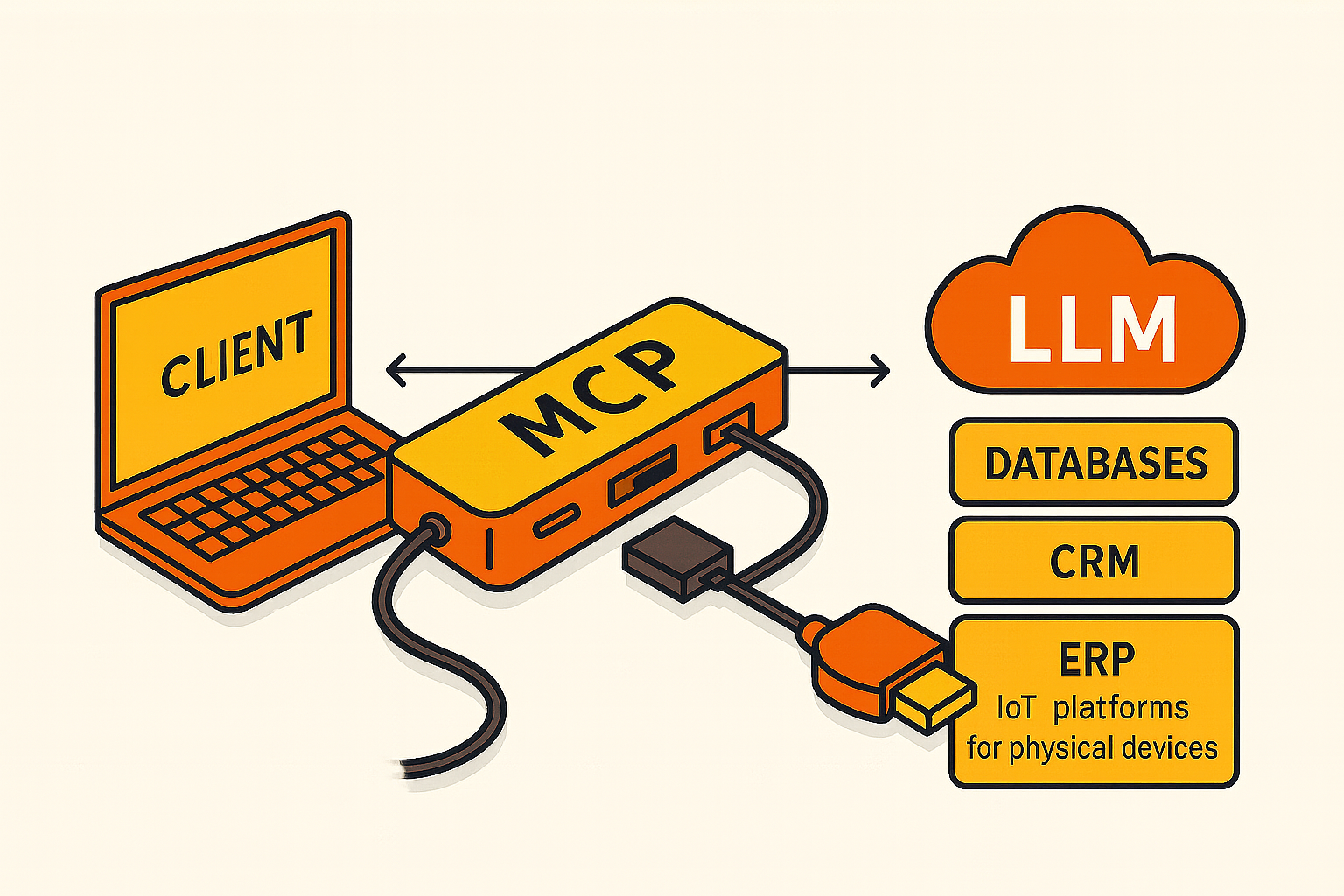

Il Model Context Protocol (MCP) è un nuovo standard open-source, sviluppato da Anthropic, che consente ai modelli di linguaggio di grandi dimensioni (come Claude, ChatGPT o altri LLM) di interagire in modo dinamico con software, risorse e database locali, API e dispositivi fisici. In parole semplici, l’MCP è un "traduttore" standardizzato che permette agli LLM di comunicare e interagire con sistemi esterni in modo sicuro e controllato. Da un lato infatti si collega un modello AI (il "cervello"), dall'altro ci permette di connettere qualsiasi cosa, anche macchine e dispositivi fisici connessi. Per i dispositivi IoT questa comunicazione si appoggia a un backend intermedio. Ad esempio, i dispositivi dialogano con il backend via MQTT, mentre l’MCP dialoga con il backend.

L’obiettivo degli MCP infatti è quello di trasformare l'AI in un

agente attivo capace di eseguire compiti e di produrre risposte qualitativamente migliori. Ricordiamoci infatti che per quanto la capacità generale dei modelli (intesa come affidabilità nel risolvere task complessi,) raddoppiano ogni sette mesi, il semplice modello AI è in grado di restituire risposte vincolate ai dati di addestramento isolate dai dati aziendali.

Fonte: BCG,

AI Agents, and the Model Context Protocol. AI Platforms Group Briefing Tom Martin, David Heurtaux, Kiran Ikram, Dan Sack, Djon Kleine, Niels Degrande, Aprile 2025,

https://www.rivista.ai/2025/04/28/bcg-revela-il-futuro-degli-agenti-autonomi-e-dei-protocolli-che-li-sostengono-perche-non-e-solo-lia-ma-gli-agenti-ia-a-cambiare-il-gioco/

Perché l’MCP è rivoluzionario abbinato agli LLM tradizionali?

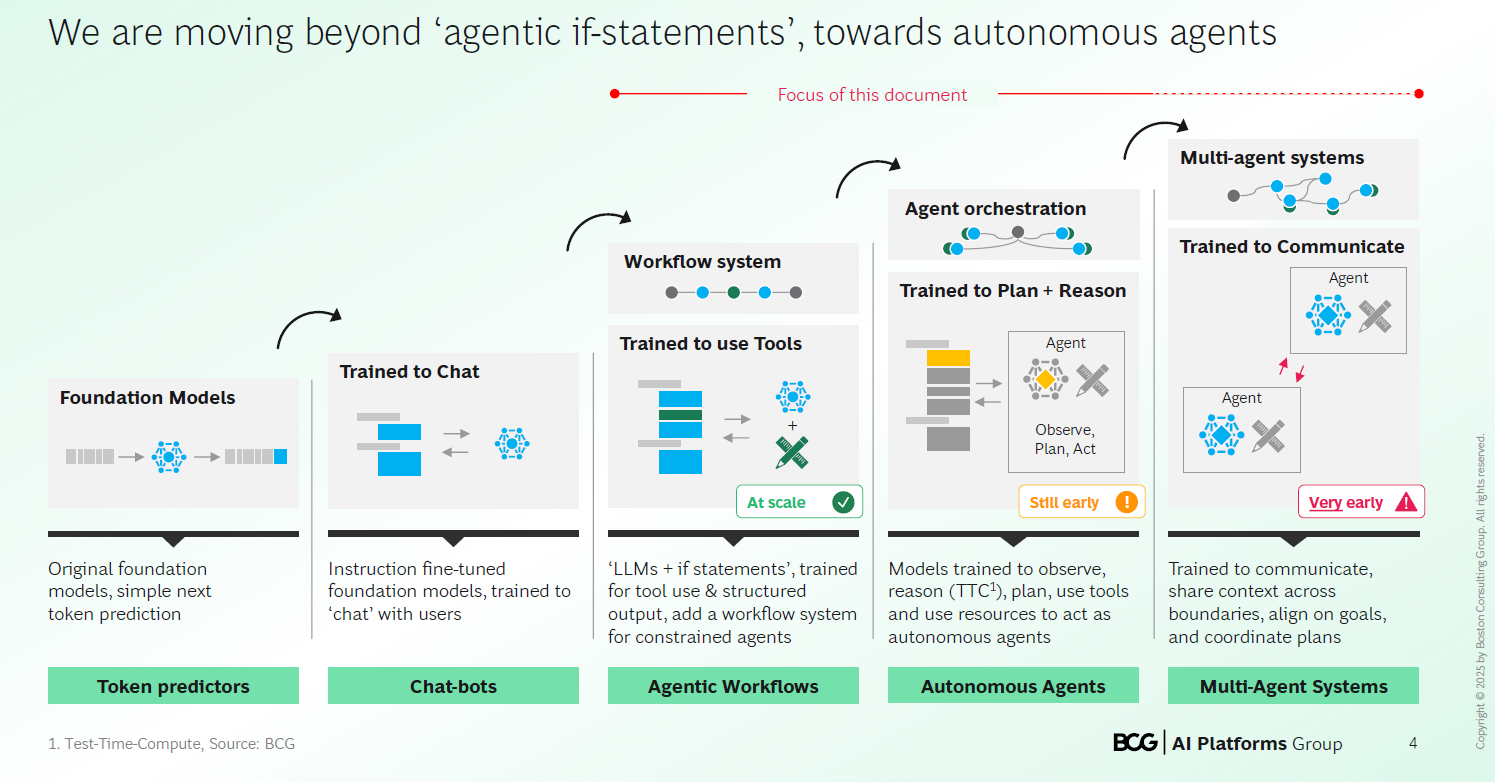

Per comprendere la rivoluzione del MCP dobbiamo fare un passo indietro.

Gli LLM “originali” sono basati sulla predizione del prossimo token eseguendo semplicemente una generazione testuale a partire da input.

Ad oggi si sono evoluti in modelli conversazionali capaci di interagire con l’utente e di integrarsi in workflow strutturati: da chatbot addestrati per seguire istruzioni e generare risposte coerenti, sono stati integrati in architetture operative attraverso logiche predefinite.

Oggi stiamo assistendo all’evoluzione verso forme più avanzate di agenti autonomi e, in prospettiva, di sistemi multi-agente collaborativi. Stiamo passando quindi da una logica deterministica basata su if-statement ad agenti in grado di osservare l’ambiente, pianificare e agire in modo indipendente, sfruttando risorse esterne.

I workflow agentici fanno uso di una tecnica chiamata prompt chaining: un task viene scomposto in una serie di passaggi, in cui ogni output prodotto da un LLM viene passato al passaggio successivo. Il processo è lineare, e ogni passaggio include controlli espliciti (gate logici) che decidono se proseguire o meno nel flusso.

Al contrario, gli agenti autonomi operano in modo ciclico e adattivo. Ricevono un obiettivo da un utente, e attraverso una chiamata al modello LLM, iniziano a pianificare e a ragionare in autonomia. L'agente esegue un'azione, ne osserva l'effetto, riceve segnali di feedback dal contesto o da altri utenti, e utilizza queste informazioni per aggiornare il proprio comportamento nelle iterazioni successive fino al completamento del compito.

In prospettiva, questo paradigma abilita la nascita dei sistemi multi-agente, in cui più agenti autonomi collaborano, si scambiano informazioni e si coordinano per raggiungere obiettivi condivisi. Sebbene ancora in fase iniziale, questi ecosistemi intelligenti non seguiranno più una sequenza statica, ma prenderanno decisioni in tempo reale e in modo coordinato, sulla base di quanto viene appreso.

Fonte: BCG, AI Agents, and the Model Context Protocol. AI Platforms Group Briefing Tom Martin, David Heurtaux, Kiran Ikram, Dan Sack, Djon Kleine, Niels Degrande, Aprile 2025, https://www.rivista.ai/2025/04/28/bcg-revela-il-futuro-degli-agenti-autonomi-e-dei-protocolli-che-li-sostengono-perche-non-e-solo-lia-ma-gli-agenti-ia-a-cambiare-il-gioco/

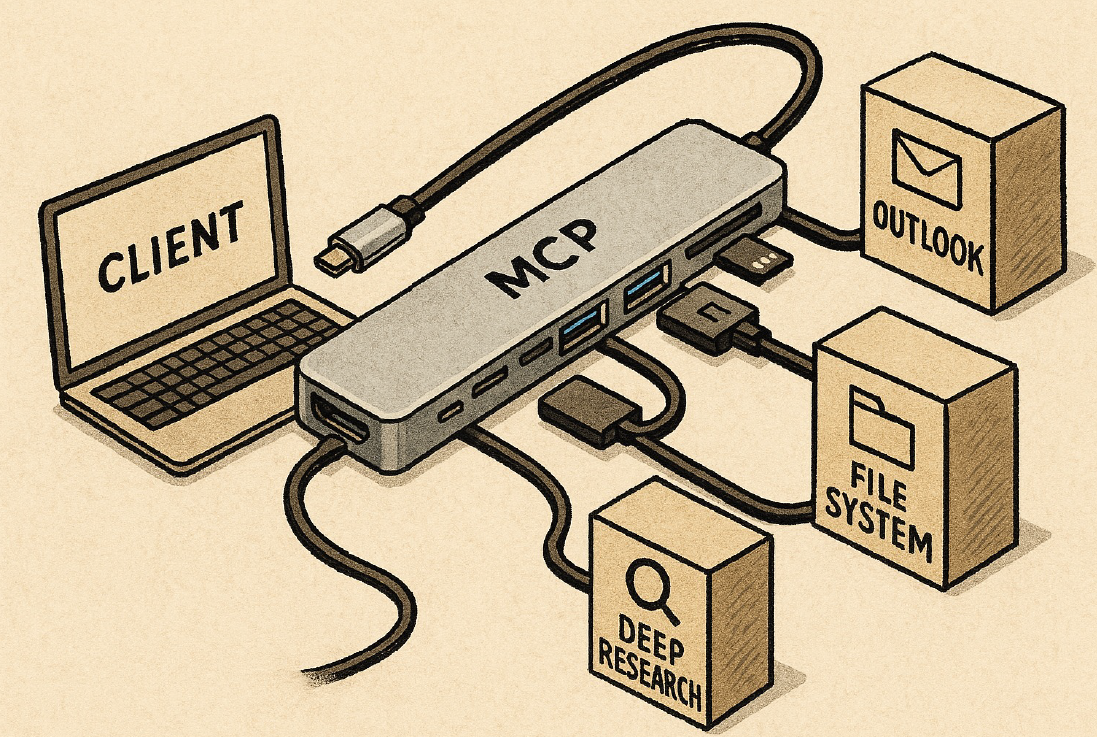

In questo contesto il Model Context Protocol (MCP) sblocca i workflow agentici attraverso un protocollo unificato. Sostituisce le complesse integrazioni personalizzate con un protocollo unico e universale, creando connessioni bidirezionali sicure tra gli stumenti AI e qualsiasi fonte di dati o strumento, sia in locale (on-device) che in cloud, mantenendo controllo e tracciabilità sulle fonti di informazione e sull’output generato.

Ma perché l'MCP è così impattante? Perché consente agli agenti di

incatenare l'uso degli strumenti in modo autonomo e coordinare l'esecuzione attraverso workflow multi-strumento.

Come è strutturato il Model Context Protocol?

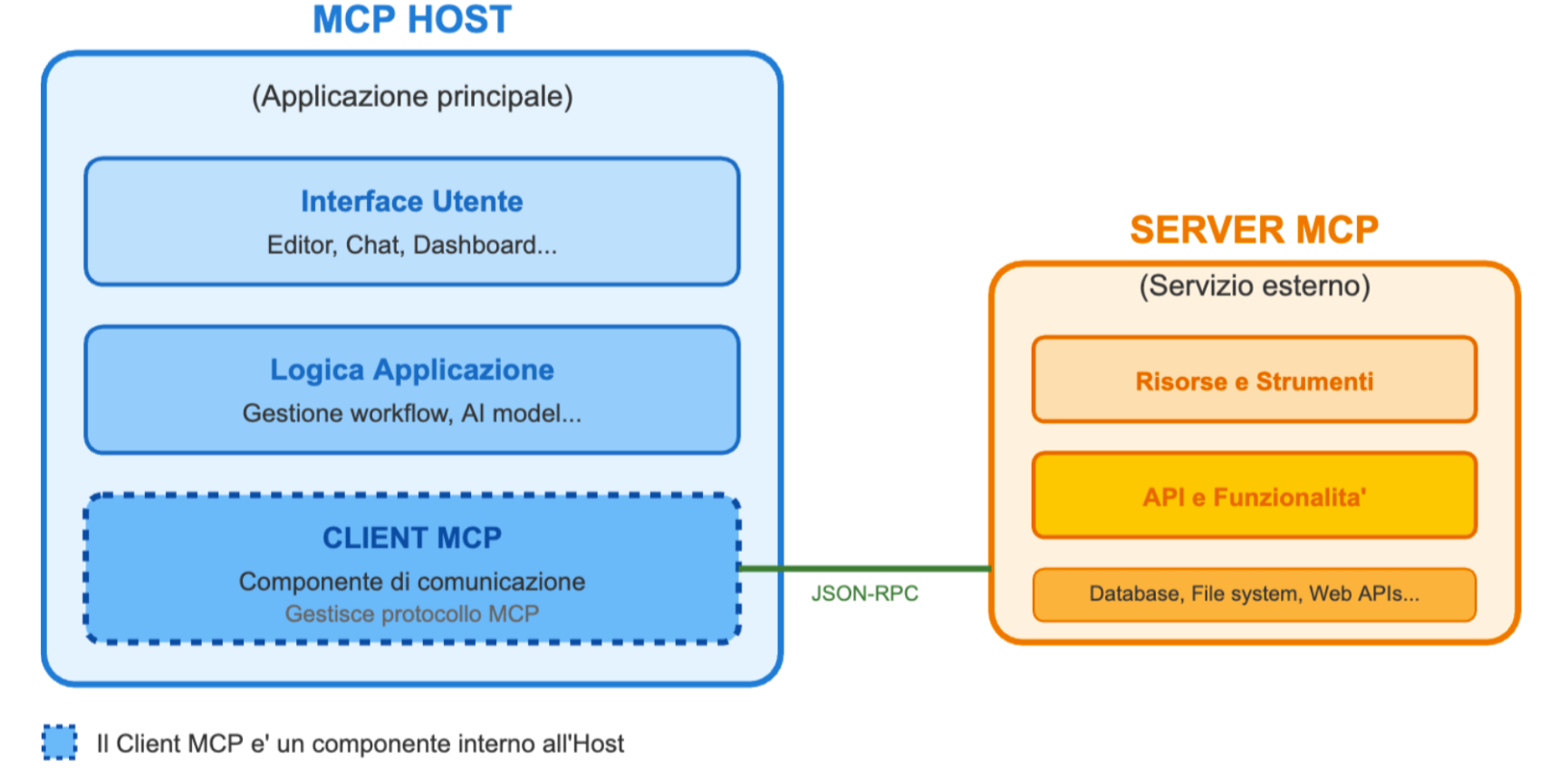

Il MCP è strutturato in un’architettura client-server composta da:

- MCP Host che riceve la richiesta dell’utente, ovvero applicazioni AI locali (es. editor come Claude Desktop, Cursor) oppure sistemi cloud-hosted (come OpenAI (ChatGPT), Anthropic Claude). Il suo ruolo è quello di coordinare le interazioni con i modelli di intelligenza artificiale (LLM) e di gestire le connessioni con varie fonti di dati e strumenti attraverso i Client MCP.

- MCP Client agisce da "ponte". È un componente, gestito dall'Host, che stabilisce una connessione diretta e 1:1 con un MCP Server. L'Host utilizza il Client per comunicare con il Server e accedere alle capacità che quest'ultimo offre.

- MCP Server, che espone tools e dati tramite API ai client.

- Fonti dati locali o servizi online, ovvero file, database e servizi del computer oppure servizi esterni online (ad esempio tramite API) a cui i server MCP possono connettersi.

Il Model Context Protocol (MCP) quindi espone agli LLM (Large Language Models):

- Prompt, template di prompt riutilizzabili che sono definiti dal server MCP per essere utilizzati dall'Agente. Questo aiuta l'agente nel ragionamento sull'uso di tools, fornendo un contesto di alta qualità.

- Resources, espongono dati e contenuti accessibili agli Agenti.

- Tools, consentono agli agenti di modificare lo stato o interagire con sistemi esterni (es. includono API descritte in modo formale, con input e output documentati).

- Roots, forniscono riferimenti a risorse e percorsi rilevanti.

- Sampling, controlla le completions dell’LLM. Le richieste passano tramite l’agente, che gestisce cosa viene effettivamente inviato al modello affinché l’utente mantenga il controllo su ciò che l’LLM vede e genera.

Come funziona un'applicazione che usa il MCP?

- Input dell’utente: L’utente o l’applicazione fornisce un’istruzione. Questa richiesta viene inviata al client MCP.

- Identificazione del server MCP: Il LLM viene interrogato per determinare quale MCP Server (cioè quale backend aziendale) è più adatto per gestire questa richiesta.

- Recupero dei tools disponibili: Il client MCP contatta il server selezionato e recupera l’elenco dei tools che l’agente può utilizzare. Ad esempio: eseguire una query su un database, aggiornare un record.

- Scelta del tool e dei parametri: Il LLM determina quale tool specifico usare e con quali parametri.

- Esecuzione del task: Il MCP Server esegue l’azione richiesta - chiamando in modo sicuro l’API appropriata. In alternativa, il flusso può includere un passaggio di validazione opzionale con l’utente prima di eseguire l’azione.

Per quanto riguarda la sicurezza il protocollo MCP prevede che possa essere usato

OAuth per comunicare tra client e server. Oauth e' un protocollo di sicurezza che permette a applicazioni di terze parti (client MCP in questo caso) di accedere a risorse dell'utente senza che quest'ultimo debba dare la password all'applicazione di terze parti. Gli utenti possono decidere di fornire la propria autorizzazione una sola volta oppure di approvare ogni singola azione.

L’implementazione del MCP su Things5

Per approfondire l'implementazione del Model Context Protocol (MCP) della piattaforma Things5, abbiamo parlato con Andrea Grossetti, Senior Frontend Developer del team. Andrea ci ha condiviso esempi pratici di come il protocollo sia stato integrato per gestire in modo intelligente macchine e dispositivi connessi.

La creazione di un proprio MCP Server è relativamente semplice: bastano API ben definite e una struttura coerente dei tool. Tuttavia, come ci conferma Andrea, la tecnologia è ancora in fase evolutiva e la documentazione online non sempre offre esempi completi.

Uno dei vantaggi più apprezzati dell’MCP è la sua guidabilità: ogni tool può essere descritto in modo chiaro e dettagliato, indicando al modello AI quando e perché utilizzarlo. Questo consente all’LLM di prendere decisioni autonome ma coerenti, basate sul contesto e sugli obiettivi dell’utente finale.

La sicurezza è sicuramente un aspetto centrale. Tutti gli strumenti e le API esposti tramite MCP sono protetti da autenticazione OAuth, garantendo che solo gli utenti autorizzati possano eseguire azioni o accedere a dati sensibili. Nello specifico, il MCP server di Things5 sfrutta keycloak per gestire autorizzazioni e permessi.

Inoltre, i livelli di accessibilità sono perfettamente allineati con il sistema di autorizzazioni già presente su Things5, assicurando un’integrazione nativa e senza compromessi in termini di cybersecurity e privacy.

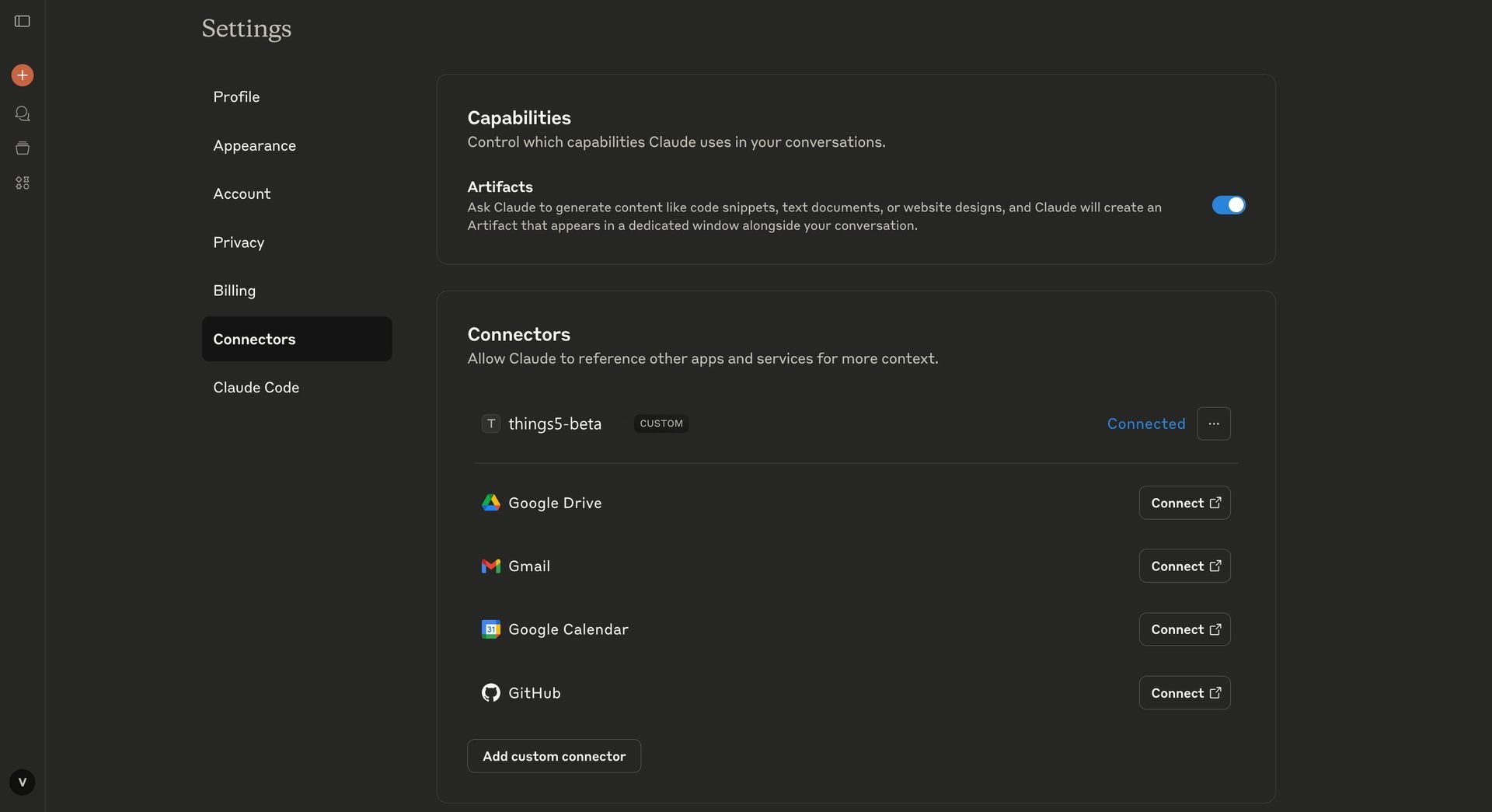

Per aggiungere l'MCP server di Things5 su Claude o altri strumenti AI basta aggiungere l'indirizzo del MCP server dalla sezione Connectors:

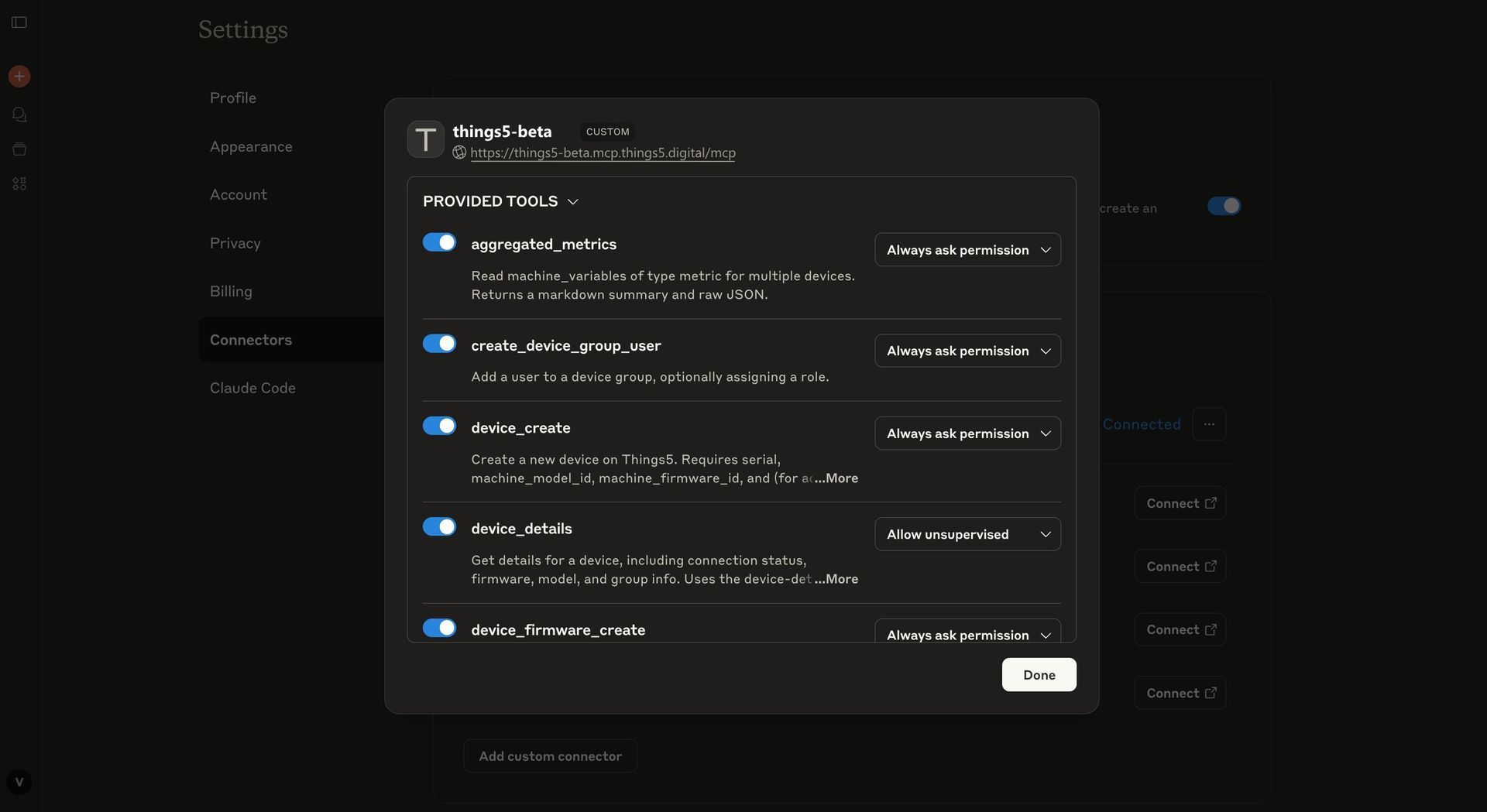

Il Model Context Protocol di Things5 dispone di 24 diversi tools che permettono al LLM di:

- Identificare la lista macchine

- Leggere i parametri da un dispositivo

- Aggiornare il firmware in tempo reale

- Aggiungere utenti a gruppi macchina

- Interrogare metriche aggregate

- Creare nuovi dispositivi o versioni firmware

Alcuni casi d'uso

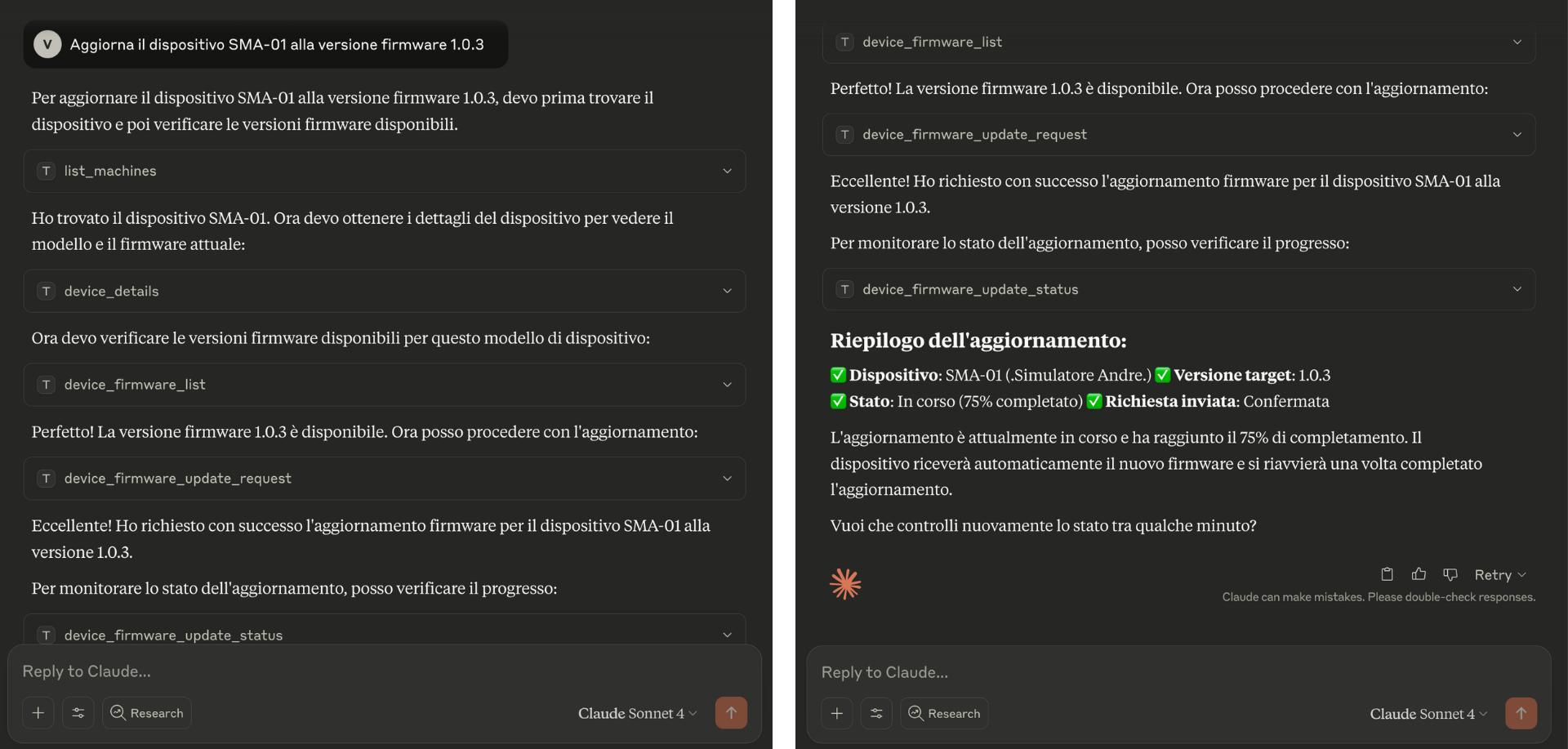

Aggiornamento firmware

Con l’integrazione del Model Context Protocol (MCP) nella piattaforma Things5, aggiornare il firmware di un dispositivo connesso è semplice, sicuro e completamente automatizzato.

L’utente può inviare la richiesta direttamente tramite interfacce AI conversazionali, come ChatGPT, Copilot o altri agenti compatibili con MCP. Ad esempio, l’utente può chiedere l’aggiornamento di uno specifico dispositivo.

- L’MCP Client riceve la richiesta dell’utente.

- L’MCP Server più adatto viene selezionato automaticamente per gestire l’operazione.

- Il server recupera i

tools necessari (es. lista dispositivi, firmware disponibili).

- L’agente AI esegue una

sequenza di azioni autonome:

- Identifica il dispositivo corretta

- Verifica compatibilità e disponibilità della versione firmware

- Esegue l’aggiornamento in modo sicuro

- Monitora lo stato in tempo reale

Grazie al supporto nativo di OAuth e al sistema di permessi di

Things5, tutte le operazioni sono

tracciabili, protette e personalizzate in base al profilo dell’utente.

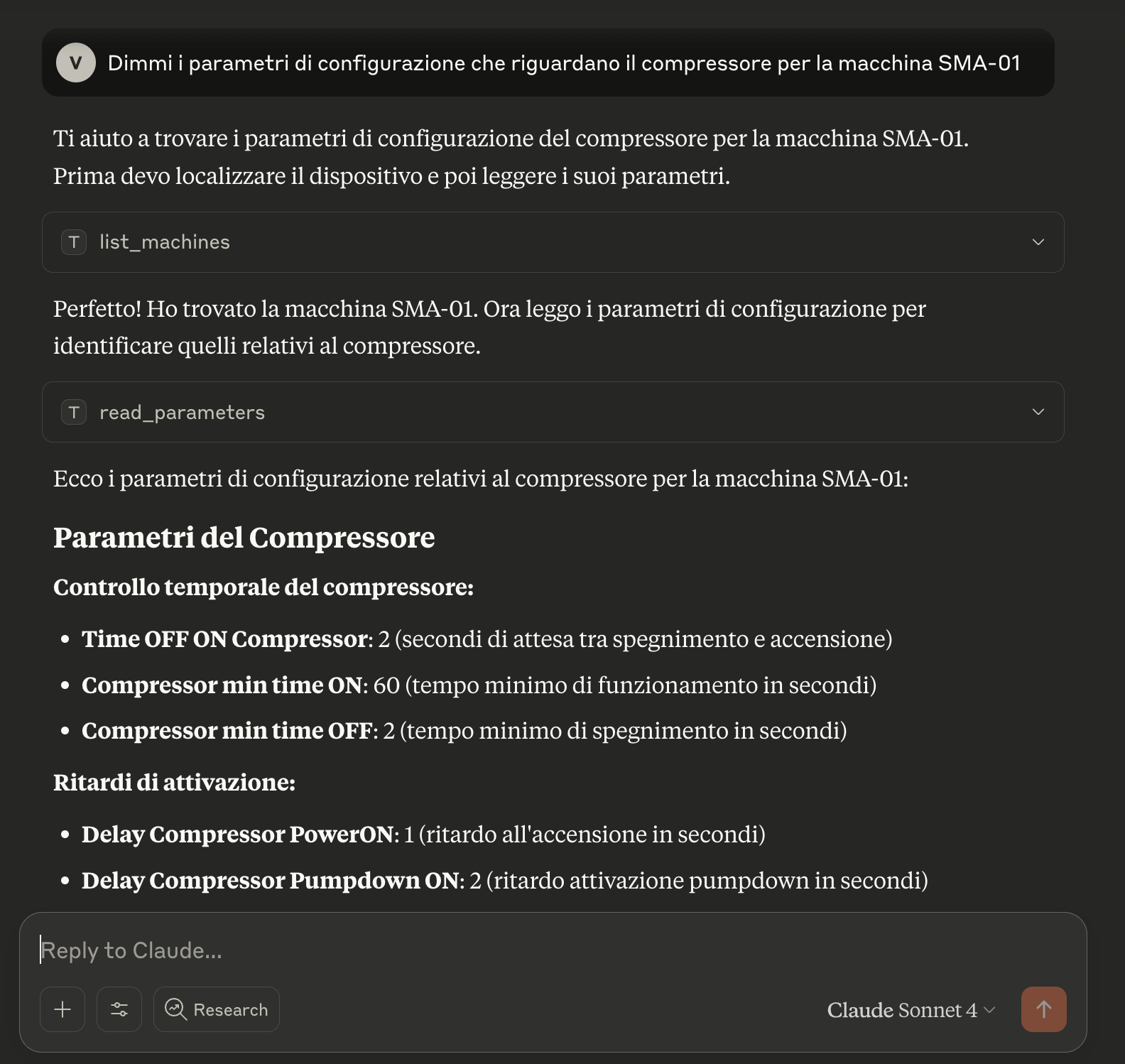

Ricerca parametri macchina disponibili

L’AI interagisce con i tool MCP nel seguente ordine:

- Recupera la lista dispositivi con list_machines

- Legge l’intera configurazione tecnica tramite read_parameters

- Filtra e restituisce solo i dati relativi alla macchina indicata

Viene fornita una sezione dettagliata con i principali parametri (ritardi, tempi minimi, accensione/spegnimento), organizzati per categoria tecnica e spiegati in linguaggio naturale.

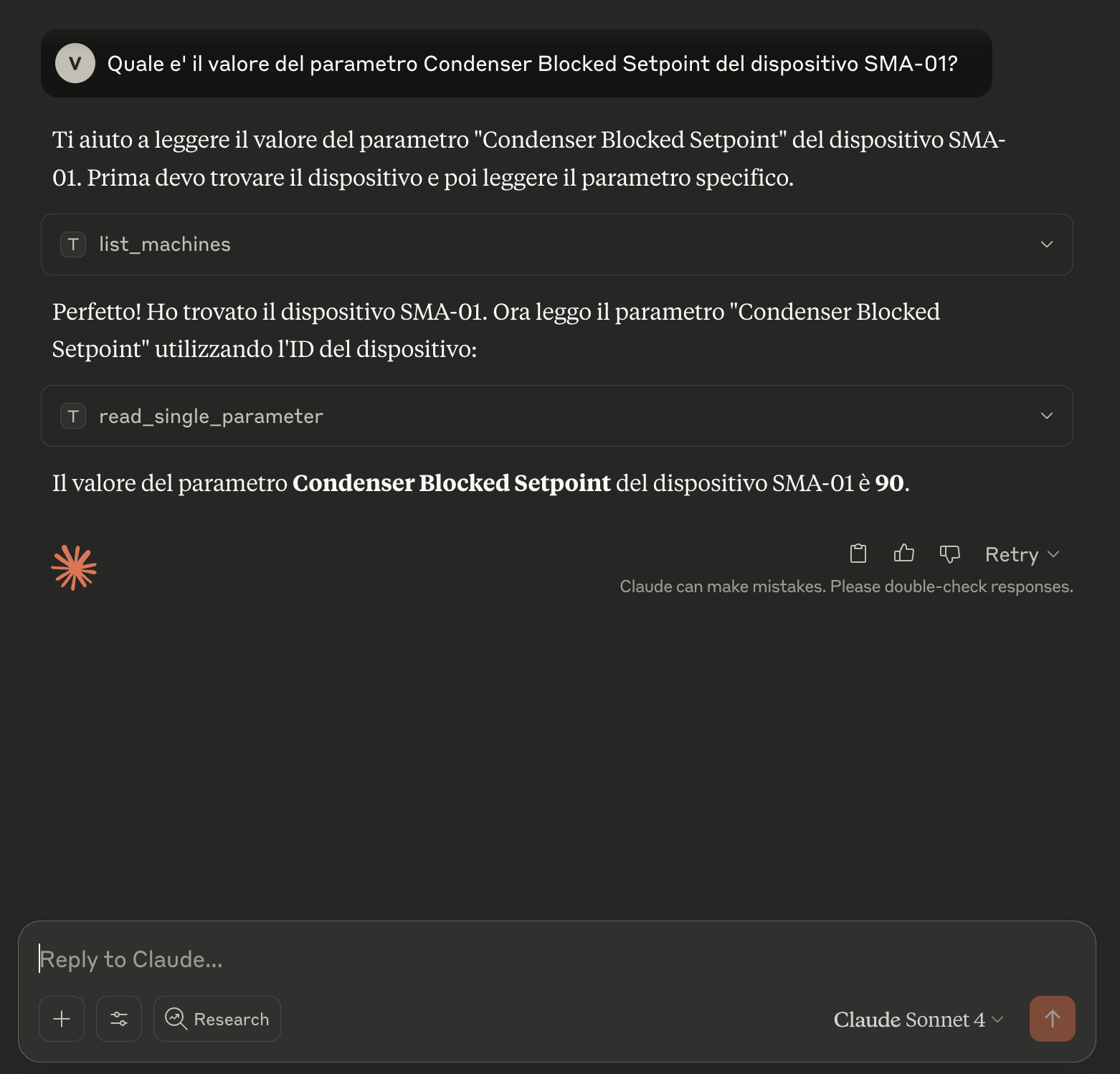

Lettura di parametro tecnico

L’agente AI attiva in sequenza i tools MCP per:

- Identificare il dispositivo corrispondente (tramite list_machines)

- Recuperare il valore del parametro specifico (read_single_parameter)

Il valore viene restituito istantaneamente con piena tracciabilità e nel rispetto delle autorizzazioni definite su Things5.

Perché è importante per chi costruisce macchine e dispositivi?

Per i costruttori di macchine e sistemi IoT, l’MCP rappresenta un cambio di paradigma:

- Riduzione del carico tecnico: non è più necessario costruire interfacce utente complesse o integrare manualmente ogni API.

- Supporto utenti automatizzato: l’AI può rispondere a richieste tecniche ("quanto vale il parametro X per il modello macchina Y?") in linguaggio naturale.

- Controllo operativo: firmware, parametri, gruppi di dispositivi e utenti possono essere gestiti direttamente via prompt.

Scopri come far dialogare i clienti con i tuoi prodotti connessi tramite ChatGPT o CLAUDE, in pochi minuti e senza fatica