Dialoga con le tue macchine come con un collega

Dati macchina ed esperienza conversazionale: come Genuin rende “parlanti” le macchine connesse

Sara Strizzolo

24 Ottobre 2025

In ogni cucina convivono diverse attrezzature professionali connesse: forni, lavastoviglie, abbattitori. Ogni macchinario è una potenziale fonte di informazioni preziose. Tuttavia, questi dati rimangono spesso inutilizzati, intrappolati in dashboard complesse e poco comprensibili. Il loro valore non risiede infatti nella sola raccolta, ma nella capacità di trasformarli in insight e azioni concrete. Nel caso della cucina avere una visione chiara del suo funzionamento permette di ridurre i consumi energetici delle macchine, ottimizzare l’utilizzo di programmi e funzionalità, garantire standard di qualità elevati e procedure ripetibili.

Genuin e, in particolare, la sua applicazione in ambito foodservice DiChef, funge in questo contesto da ponte tra il mondo dell'IoT e un’esperienza utente semplice e personalizzata che permette allo staff di cucina di dialogare con le proprie macchine ed ottenere le informazioni necessarie.

La logica di interazione e gestione dei dati IoT

Nell’esperienza conversazionale di Genuin l'utente dialoga direttamente e in linguaggio naturale con la macchina. L’elemento innovativo, rispetto alle tradizionali esperienze conversazionali testuali (ovvero via chat scritta), è quello di combinare input vocale con l'interfaccia visuale. Genuin infatti genera interfacce visuali che completano perfettamente la conversazione vocale in tempo reale. Questo significa che, per generare un’interfaccia personalizzata basata sulle specifiche richieste dell’utente (immaginiamo ad esempio le analisi sul consumo energetico di una macchina, informazioni sul suo settaggio o su una specifica ricetta caricata), l’assistente DiChef deve interpretare la richiesta dell’utente mediante un LLM, comprendere le informazioni di contesto che devono essere utilizzate per la generazione della risposta e recuperare i dati dalle piattaforme IoT attive per agire in modo controllato sul dispositivo.

La condizione di base è la connettività delle macchine ad Internet: le macchine devono poter inviare e ricevere dati, tramite una scheda integrata oppure attraverso un gateway. Questo rende disponibili in cloud stati operativi, log, allarmi e parametri, programmi macchina caricati, che DiChef può utilizzare per rispondere all’utente.

La comunicazione può avvenire in rete locale (BLE, LAN, Ethernet) per operazioni rapide e a bassa latenza, oppure via Internet passando dai servizi esposti dai costruttori attraverso API. Per i brand già integrati, Things5 Connect, il modulo della nostra piattaforma cloud e modulare dedicato alla connettività, abilita la connessione delle macchine al cloud per la gestione e il loro monitoraggio da remoto.

La sicurezza rimane un aspetto centrale. Nell’interazione con la macchina, è importante garantire infatti che ogni utente possa accedere solo alle informazioni e ai dati che gli sono stati abilitati attraverso l’autenticazione. Tutti i dati esposti dalla macchina al Motore di Composizione Generativa vengono quindi filtrati nella valutazione del contesto: chi è l’utente, quali permessi ha, quale macchina è in uso, lo stato operativo e gli ultimi eventi, il tempo e il luogo della richiesta, nonché dati storici utili (consumi, cicli, allarmi ricorrenti). In base a questo contesto sceglie le informazioni rilevanti, decide se chiedere dettagli aggiuntivi e

genera l’interfaccia più adatta in quel momento così da mostrare solo ciò che serve davvero.

Il ruolo del protocollo MCP

Per mettere in comunicazione la piattaforma IoT Things5 con il LLM, rendendo dati e funzioni accessibili, abbiamo implementato un server MCP (Model Context Protocol) che permette all’assistente DiChef di accedere in modo sicuro e controllato a tutte le funzionalità esposte dalla piattaforma. Per MCP si intende uno standard open-source che consente ai modelli di linguaggio (come Claude, ChatGPT e altri LLM) di interagire in modo dinamico con software, risorse e database locali, API e dispositivi fisici.

In pratica, l’utente formula una richiesta, il LLM ne comprende l’intento e, tramite MCP, accede alla funzione più adatta: leggere un parametro, modificare una configurazione, interrogare una metrica o avviare un’operazione. L’architettura client-server del protocollo fa da interprete tra il modello e i servizi terzi e/o macchine, mantenendo così il controllo su permessi e conferme operative fondamentali per garantire la sicurezza dell’operatore sulla macchina.

Com’è strutturato il Model Context Protocol

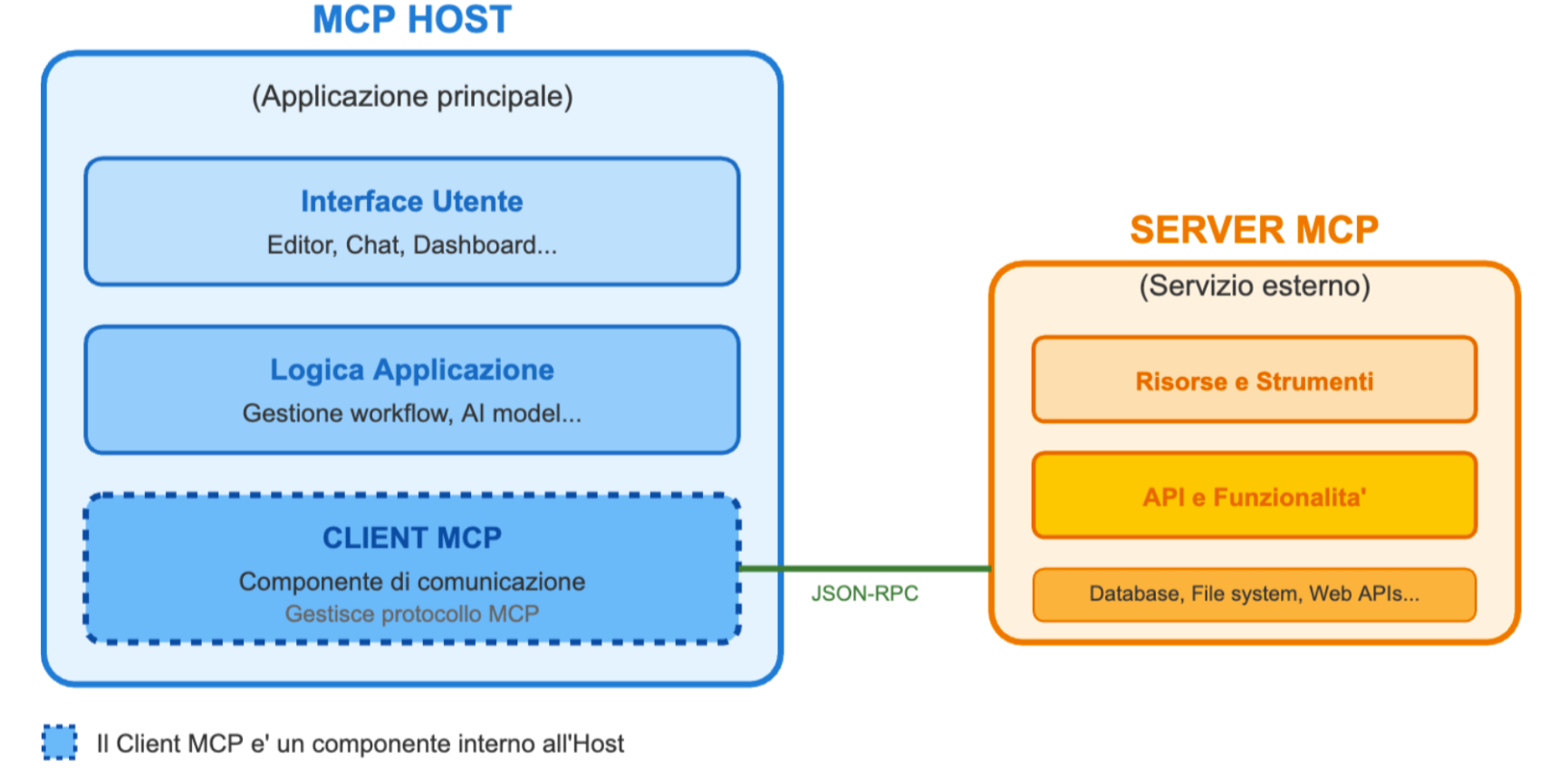

Come anticipato, il Model Context Protocol (MCP) adotta un’architettura client-server composta da tre elementi principali.

L’MCP Host riceve le richieste dell’utente ed è l’applicazione AI che coordina le interazioni con i modelli di linguaggio (LLM) e le connessioni con varie fonti di dati e strumenti attraverso i Client MCP. Può essere un’app locale, come editor tipo Claude Desktop o Cursor, oppure un sistema in cloud come OpenAI (ChatGPT) o Anthropic Claude.

Il MCP Client funge da ponte: è gestito dall’Host e stabilisce una connessione diretta “uno a uno” con un MCP Server.

Il MCP Server espone strumenti (tool) e dati tramite API, consentendo all’Host di accedervi attraverso il Client.

A questi server possono essere collegati sia fonti dati locali (file, database, servizi del computer) sia servizi online raggiungibili via API.

Tra gli elementi che il Model Context Protocol (MCP) espone agli LLM (Large Language Models) i tools sono uno degli elementi più importanti per DiChef. Sono infatti necessari affinché gli assistenti possano modificare lo stato e interagire con sistemi esterni.

Come funziona un’applicazione che usa MCP

É importante quindi capire come funziona un’applicazione che sfrutta il Model Context Protocol per comprendere il flusso logico.

L’utente o l’applicazione fornisce un’istruzione; la richiesta arriva al Client MCP. Il modello di linguaggio viene quindi interrogato per decidere quale Server MCP (in pratica, quale backend aziendale) sia più adatto a gestirla. Il Client contatta quindi il Server selezionato e recupera l’elenco dei tool disponibili. A questo punto il LLM sceglie quale tool utilizzare e con quali parametri e il Server esegue l’azione chiamando in modo sicuro l’API appropriata. Se previsto, può essere richiesto un passaggio di validazione con l’utente prima dell’esecuzione definitiva.

Nell’implementazione MCP di

Things5 sono disponibili

34 tool che permettono al modello di linguaggio di eseguire le principali operazioni: identificare l’elenco delle macchine, leggere parametri da un dispositivo, aggiornare il firmware in tempo reale, gestire gli utenti e i gruppi macchina, interrogare metriche aggregate, creare nuovi dispositivi o nuove versioni firmware. Tutto questo avviene senza aggiungere complessità all’esperienza, l’elaborazione congiunta del LLM e del MCG genera un risultato strutturato che viene presentato all’operatore in linguaggio naturale e visuale.

La combinazione di LLM e MCG per la gestione input-output attraverso comandi vocali

Ripercorriamo quindi l’intero processo dell’interazione per comprendere meglio come LLM e MCG, quando combinati congiuntamente possono generare un’esperienza del tutto naturale e seamless con la macchina.

L’utente formula la richiesta a voce e in linguaggio naturale; dopo un passaggio speech-to-text, il LLM interpreta l’input, estrae l’intento della richiesta e definisce il contesto (fase di INTENT RECOGNITION), così da individuare quali skill dell’agente attivare, ovvero quali aree di competenza richiamare per la formulazione della risposta.

La ricerca delle skill avviene sulla base di un prompt progettato ad hoc: l’agente costruisce una rappresentazione interna della richiesta e la riformula coerentemente con la conversazione in corso. Questa fase di INTENT MATCHING unisce ciò che l’utente vuole fare con le reali competenze disponibili dell’agente.

Le skill sono procedure che utilizzano i tool esposti via MCP secondo un flusso predefinito. Vengono configurate in anticipo nell’editor no-code di Genuin, dove un modello di AI generativa supporta la definizione delle skill e dei relativi diagrammi di flusso. Se i parametri forniti dall’utente sono sufficienti, l’esecuzione prosegue; in caso contrario, l’interfaccia richiede i dati mancanti. A questo punto il LLM seleziona la skill più adatta in funzione dei tool disponibili, e il MCP ne abilita l’applicazione: il sistema chiama infatti connettori o API delle macchine passando parametri strutturati.

Ricevuto l’esito dai tool, il LLM lo riconverte in linguaggio naturale e, se necessario, lo trasforma in audio per la restituzione vocale. In parallelo, l’output viene inviato al MCG, che produce uno schema parametrico dell’interfaccia e lo consegna al frontend per il rendering. Questa fase di RESPONSE GENERATION, unita all’output multimodale, rappresenta l’aspetto più innovativo del sistema: il LLM fornisce risposte contestuali mentre il MCG genera una UI dinamica facendo convergere testo/voce e interfacce generate dinamicamente in un’unica esperienza fluida.

Evoluzioni future

Genuin, e la sua applicazione al contesto del foodservice DiChef, dimostra che il vero valore dei dati macchina non è nella raccolta, ma nella loro trasformazione in decisioni operative chiare e immediate. L’integrazione tra LLM e Motore di Composizione Generativa consente di passare velocemente dalla richiesta in linguaggio naturale all’esecuzione controllata di macchine e dispositivi, con un’interfaccia che si adatta al contesto e mostra solo ciò che serve.

In cucina questo significa riduzione dei tempi morti, efficientamento dei consumi energetici e dell’utilizzo di risorse, qualità del servizio e standardizzazione dei processi.

Dal punto di vista architetturale, il disaccoppiamento tra comprensione linguistica ed esecuzione tecnica della richiesta crea una base solida per la scalabilità del sistema e la gestione di interi ecosistemi di dispositivi connessi.

L’evoluzione naturale del sistema va in tre direzioni. La prima è portare sempre più capacità “a bordo” macchina, con canali diretti a bassa latenza che garantiscano continuità anche in assenza di connettività cloud. La seconda è arricchire il catalogo di tool MCP e le skill, così che l’assistente possa coprire casi d’uso più avanzati: diagnosi avanzata, ottimizzazione automatica di cicli, suggerimenti proattivi basati su pattern storici. Il terzo obiettivo è l'universalità. In ambienti professionali multiculturali come le cucine, la comunicazione non può avere barriere. Per questo, il nostro sistema è progettato per essere multilingue: nato in inglese, parla già italiano ed è pronto ad apprendere nuove lingue, garantendo un'interazione naturale e inclusiva che valorizza il contributo di ogni operatore.

In prospettiva, ogni nuova macchina connessa diventa una fonte di apprendimento e ogni conversazione un’occasione per migliorare. Genuin consolida così un circolo virtuoso: i dati alimentano l’assistente, l’assistente abilita azioni utili, le azioni generano nuovi dati di qualità. Il risultato diventa quindi un ecosistema che si aggiorna nel tempo ed estende il ciclo di vita dei prodotti.

Progetto finanziato dall’Unione europea – Next Generation EU